Carros Autônomos e Ética: Decisões Morais na Programação de Veículos

Em um futuro não tão distante, veículos sem motoristas humanos circularão pelas vias urbanas e rodovias, transformando radicalmente nosso relacionamento com o transporte. Sistemas de direção autônoma já são uma realidade em desenvolvimento acelerado, com empresas como Tesla, Waymo, Mercedes-Benz e Baidu investindo bilhões em pesquisa e implementação. Entretanto, à medida que delegamos a responsabilidade pela segurança no trânsito a algoritmos e sistemas de inteligência artificial, surgem questões éticas complexas que vão muito além da mera capacidade técnica.

Um veículo autônomo não é apenas uma máquina projetada para navegar de um ponto a outro — é um agente que precisará tomar decisões instantâneas com potenciais implicações morais profundas. Tais decisões, anteriormente delegadas ao julgamento humano, agora precisam ser codificadas em algoritmos previsíveis e sistemáticos. Quando a segurança de motoristas, passageiros e pedestres está em jogo, quais valores devem orientar essas escolhas algorítmicas? E quem tem o direito de estabelecê-las?

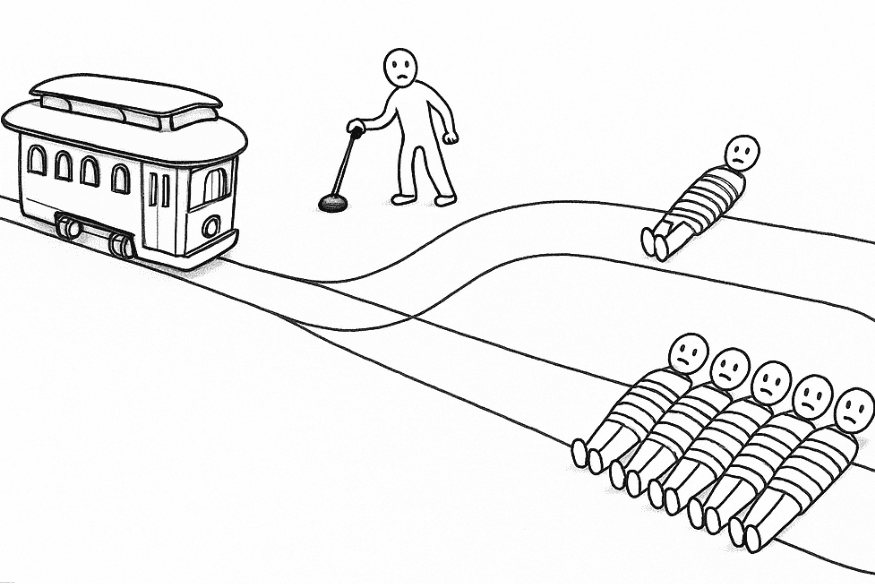

O Dilema do Bonde em Alta Velocidade

O debate sobre a ética dos veículos autônomos frequentemente invoca variações do clássico “problema do bonde” (trolley problem) — um experimento mental filosófico onde uma pessoa precisa decidir se desvia um bonde desgovernado para uma via onde matará uma pessoa, em vez de cinco na via original.

Imagine um carro autônomo trafegando em alta velocidade quando crianças repentinamente atravessam a rua. O sistema detecta que uma frenagem completa será insuficiente para evitar o atropelamento. As opções algorítmicas incluem:

- Manter o curso, resultando no atropelamento das crianças

- Desviar para o acostamento, possivelmente matando os ocupantes do veículo

- Desviar para a contramão, arriscando uma colisão com veículos em sentido contrário

Qual decisão o algoritmo deveria priorizar? A proteção dos passageiros a todo custo? A minimização do número total de vítimas? A proteção dos mais vulneráveis, como crianças e idosos?

Diferentemente de acidentes com condutores humanos, que reagem instintivamente em frações de segundo, as decisões programadas em veículos autônomos são resultado de escolhas deliberadas feitas por engenheiros e designers de sistemas. Isso cria um nível de responsabilidade moral sem precedentes na história do transporte.

Abordagens Éticas para a Programação de Veículos Autônomos

Utilitarismo: Minimizando o Dano Total

Uma abordagem ética possível é programar veículos para minimizar o dano total em qualquer situação. Sob essa perspectiva utilitarista, o algoritmo seria programado para calcular o curso de ação que provavelmente resultaria no menor número de feridos ou mortos.

O MIT criou um experimento chamado “Moral Machine” que apresentou dilemas éticos para milhões de participantes em todo o mundo. O experimento, que foi concluído em 2020, coletou cerca de 40 milhões de decisões de pessoas em 233 países e territórios, tornando-se um dos maiores estudos globais já realizados sobre preferências morais. Os resultados, publicados na revista Nature em 2018, mostraram que, embora haja consenso sobre salvar o máximo de vidas, existem variações culturais significativas sobre quais vidas priorizar. Por exemplo, algumas culturas tendem a valorizar mais a juventude, enquanto outras priorizam a hierarquia social (Awad et al., 2018).

A implementação de uma ética puramente utilitarista, contudo, levanta preocupações. Seria aceitável um veículo calcular o “valor social” relativo de diferentes vidas humanas? Um algoritmo deveria pesar a idade, estado de saúde ou número de dependentes das potenciais vítimas?

Contratualismo: Protegendo os Passageiros

Uma abordagem alternativa enfatiza o “contrato” implícito entre o veículo e seus ocupantes. Sob essa perspectiva, o algoritmo deve priorizar a proteção dos passageiros acima de tudo, mesmo que isso resulte em danos maiores a terceiros.

Defensores desta perspectiva argumentam que poucos consumidores comprariam veículos programados para sacrificar seus ocupantes em determinadas circunstâncias. Além disso, essa abordagem mantém a analogia com a condução humana, onde motoristas instintivamente protegem a si mesmos e seus passageiros em situações de emergência.

Críticos, por outro lado, apontam que essa abordagem poderia criar uma sociedade onde passageiros de veículos autônomos seriam privilegiados em detrimento de pedestres e ciclistas, aprofundando desigualdades sociais relacionadas à mobilidade.

Deontologia: Seguindo Regras Absolutas

Uma terceira perspectiva, baseada na ética deontológica kantiana, sugere que veículos autônomos devem seguir regras morais absolutas, independentemente das consequências. Por exemplo: “nunca direcionar ativamente o veículo para atropelar uma pessoa” ou “sempre priorizar a segurança de crianças”.

Essa abordagem oferece clareza moral e alinhamento com intuições éticas fundamentais. Entretanto, ela pode falhar em situações complexas onde múltiplas regras entram em conflito ou quando seguir rigidamente uma regra resulta em consequências catastróficas.

Questões de Transparência e Responsabilidade

A questão de quem decide os parâmetros éticos dos veículos autônomos é tão importante quanto as decisões em si. Atualmente, tais escolhas são feitas principalmente por:

- Engenheiros e programadores das empresas de tecnologia

- Executivos e departamentos jurídicos dessas corporações

- Agências reguladoras governamentais (com diferentes níveis de envolvimento)

Esta situação levanta preocupações sobre transparência e responsabilidade democrática. Deveria o público participar nas decisões sobre como veículos autônomos resolverão dilemas éticos? Como equilibrar a necessidade de inovação tecnológica com a supervisão democrática?

Alguns especialistas propõem a criação de comitês de ética em IA com participação multidisciplinar — incluindo engenheiros, filósofos, sociólogos, especialistas em segurança e representantes da sociedade civil. Outros sugerem que cada proprietário deveria poder escolher entre diferentes “perfis éticos” para seu veículo autônomo, refletindo seus próprios valores.

Implicações Legais e Responsabilidade no Brasil

No Brasil, a regulamentação de veículos autônomos está começando a tomar forma através do Projeto de Lei 1317/23, apresentado pelo deputado Alberto Fraga, que visa alterar o Código de Trânsito Brasileiro para incluir regras específicas para veículos autônomos. A proposta define veículo autônomo como aquele “com qualquer tipo de motorização e que não dependa de condutores humanos para seu deslocamento, utilizando tecnologia computadorizada georreferenciada, com tomada de decisões por meio de inteligência artificial” (Câmara dos Deputados, 2023).

Um dos pontos centrais da proposta brasileira é a responsabilidade em caso de acidentes ou infrações. Segundo o PL 1317/23, a responsabilidade “será apurada conforme cada caso, podendo ser exclusiva ou solidária entre fabricante (ou seu representante no Brasil) e proprietário (ou condutor)”. A proposta também estabelece que a responsabilidade será exclusiva de quem agir com negligência, imprudência ou imperícia na programação ou manutenção do veículo (Câmara dos Deputados, 2023).

Outro ponto importante da lei brasileira em discussão é a exigência de um seguro obrigatório contra acidentes para todos os veículos autônomos, com cobertura para terceiros, além da criação de um cadastro nacional para registrar todos os tipos de acidentes com esses veículos. Esta abordagem busca equilibrar a responsabilidade entre fabricantes e proprietários, reconhecendo que ambos podem contribuir para falhas que levem a acidentes.

O Paradoxo da Segurança e da Aceitação Pública

Um aspecto particularmente desafiador é que veículos autônomos provavelmente enfrentarão um padrão duplo em relação à segurança. Embora motoristas humanos causem milhões de acidentes anualmente por desatenção, intoxicação ou erro de julgamento, acidentes com veículos autônomos tendem a gerar muito mais atenção e preocupação pública.

Estudos indicam que veículos autônomos precisarão ser significativamente mais seguros que motoristas humanos para alcançar aceitação pública. Ironicamente, essa relutância em adotar uma tecnologia imperfeita — mesmo quando superior à alternativa humana — pode retardar a implementação de sistemas que salvariam milhares de vidas anualmente.

Essa dinâmica cria um desafio tanto técnico quanto ético: como balancear a melhoria incremental da segurança através da implementação de sistemas imperfeitos contra o desejo justificável por tecnologias próximas da perfeição quando vidas estão em jogo?

A Dimensão Global da Ética em Veículos Autônomos

O debate sobre veículos autônomos e ética tem ainda uma dimensão global. O estudo “Moral Machine” do MIT revelou variações culturais significativas nas intuições éticas sobre como veículos autônomos deveriam priorizar diferentes vidas em situações de inevitável dano.

O pesquisador Edmond Awad, um dos autores do estudo, ressalta que algumas preferências reveladas no experimento são preocupantes, como a tendência de pessoas priorizarem indivíduos de maior status social. “Parece preocupante que as pessoas realmente consideraram aceitável a um nível significativo salvar alguém de maior prestígio acima de alguém com menos”, afirmou Awad em entrevista à MIT Technology Review (2021).

Isso levanta questões sobre padronização internacional: deveria um mesmo veículo autônomo tomar decisões diferentes dependendo do país onde opera? Como empresas globais de tecnologia deveriam lidar com a diversidade de valores culturais? Quem tem autoridade moral para estabelecer padrões universais neste domínio?

Para Além dos Dilemas Extremos

Embora os dilemas tipo “problema do bonde” capturem a imaginação, a ética dos veículos autônomos vai muito além desses cenários extremos. Questões mais cotidianas também merecem consideração:

- Quão cauteloso ou agressivo deve ser um veículo autônomo no trânsito?

- Como equilibrar segurança com eficiência de tráfego?

- Deveria o conforto dos passageiros influenciar as decisões dos veículos?

- Como lidar com pedestres que desrespeitam regras de trânsito?

Estas perguntas aparentemente mundanas também incorporam julgamentos de valor que designers de sistemas precisam codificar explicitamente.

Conclusão: O Imperativo da Deliberação Ética

À medida que veículos autônomos se aproximam da adoção em massa, a deliberação ética não pode mais ser adiada. Talvez pela primeira vez na história, temos a oportunidade de debater explicitamente e escolher conscientemente os valores embutidos em nosso sistema de transporte, em vez de simplesmente aceitar as consequências emergentes de decisões individuais não coordenadas.

O debate sobre ética em veículos autônomos também serve como um microcosmo para questões mais amplas sobre a crescente autonomia dos sistemas de inteligência artificial em nossa sociedade. As lições aprendidas neste domínio poderão informar abordagens éticas para outras tecnologias emergentes.

No Brasil, a discussão sobre regulamentação de veículos autônomos está apenas começando, com o PL 1317/23 ainda em tramitação na Câmara dos Deputados. Esta é uma oportunidade importante para que a sociedade brasileira participe ativamente na definição dos parâmetros éticos que guiarão essa tecnologia no país.

Independentemente das respostas específicas que desenvolvermos, o processo de questionar, debater e chegar a um consenso sobre esses dilemas é tão importante quanto as conclusões finais. O verdadeiro desafio não é apenas programar veículos autônomos para tomar decisões morais, mas garantir que essas decisões reflitam nossos valores coletivos, promovam o bem comum e distribuam justamente os benefícios e riscos desta tecnologia transformadora.

Quando os carros do futuro enfrentarem suas inevitáveis situações de escolha moral, que suas decisões reflitam não apenas a eficiência algorítmica, mas também nossa humanidade coletiva e aspirações éticas compartilhadas.

Referências

- Superinteressante: A máquina moral

- Senna Martins: Regulação de Veículos Autônomos no Brasil

- O Antagonista: Carros autônomos: Como está a regulamentação em 2025

- Blog Zignet: Veículos autônomos: desafios e impacto no trânsito

- Revista Sísifo: Serious game ético: A “Máquina Moral” do MIT como educadora